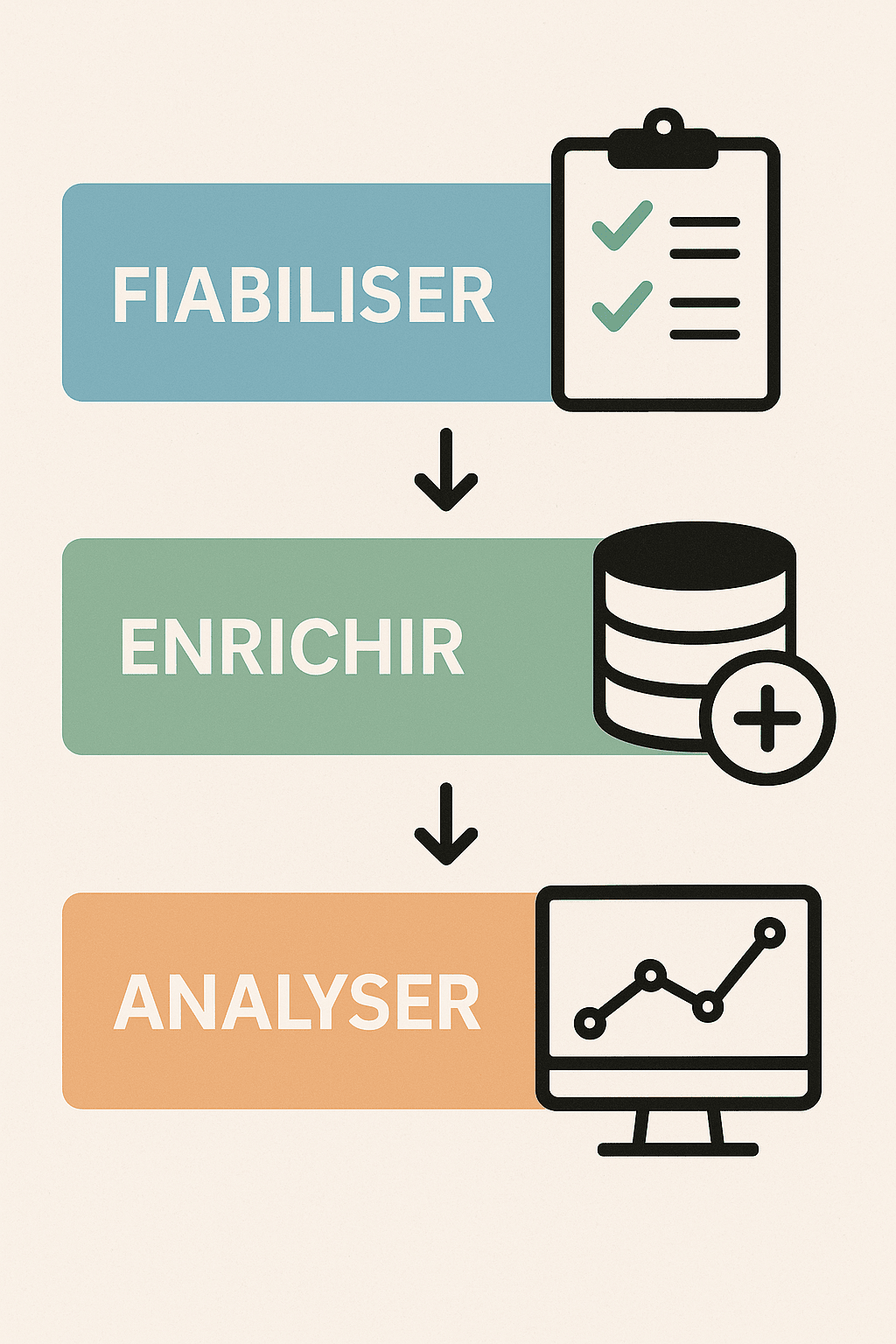

Dans l’urgence de “faire parler la donnée”, beaucoup d’entreprises se lancent directement dans l’analyse ou le reporting automatisé. Mais sans base solide, aucune intelligence artificielle ne peut tirer des conclusions fiables. Les projets data performants suivent une logique simple : Fiabiliser la donnée avant de l’enrichir, puis seulement l’analyser. C’est la seule manière d’obtenir des insights cohérents, exploitables et durables.

La fiabilisation des données consiste à garantir leur qualité, leur cohérence et leur complétude avant toute exploitation. Cette étape est souvent sous-estimée, alors qu’elle conditionne la réussite de tout projet d’analyse ou d’intelligence artificielle. Fiabiliser, c’est s’assurer que les informations sur lesquelles reposent les décisions stratégiques sont exactes, à jour et uniformisées.

Concrètement, cela passe par le nettoyage des doublons, la correction des anomalies, la vérification des formats, et l’harmonisation des sources issues de différents systèmes (ERP, CRM, e-commerce, etc.). Une donnée fiabilisée est une donnée sur laquelle on peut bâtir des modèles, des rapports et des prédictions fiables. Sans cela, même le meilleur algorithme produira des résultats biaisés.

Une fois les données fiabilisées, l’étape suivante consiste à les enrichir. L’objectif est d’apporter du contexte, de la profondeur et de la pertinence. L’enrichissement transforme une donnée brute en une donnée intelligente, capable d’éclairer les décisions.

Il peut s’agir d’intégrer des données externes (open data, données de marché, météo, géolocalisation, tendances sectorielles) ou de croiser des sources internes pour révéler des liens invisibles entre la logistique, le commercial ou le marketing. Par exemple, relier les ventes à la météo ou à la saisonnalité permet de dégager des modèles prédictifs bien plus précis.

L’enrichissement est ce qui fait passer une organisation d’une logique descriptive (“ce qui s’est passé”) à une logique explicative et prospective (“pourquoi cela s’est passé et que va-t-il se passer”).

Ce n’est qu’après avoir fiabilisé et enrichi la donnée que vient le moment de l’analyse. C’est l’étape la plus visible, celle qui concrétise tout le travail de préparation. L’analyse permet de transformer les données en indicateurs, tendances et recommandations exploitables.

Grâce à des tableaux de bord intelligents, des modèles prédictifs ou des assistants IA, les entreprises peuvent identifier les leviers de performance, détecter des anomalies et simuler différents scénarios. Mais l’analyse ne vaut que si les deux premières étapes ont été respectées : sans données fiables et enrichies, l’interprétation devient aléatoire.

L’enjeu n’est donc pas seulement de “faire parler” la donnée, mais de lui donner une voix fiable, claire et utile pour la prise de décision.

La donnée est aujourd’hui le carburant de toute transformation numérique. Pourtant, la plupart des entreprises oublient qu’avant de vouloir analyser, il faut d’abord fiabiliser et enrichir. L’intelligence artificielle n’est performante que lorsqu’elle s’appuie sur une base solide et structurée.

Chez Strat37, nous accompagnons les entreprises à chaque étape de ce parcours : fiabiliser leurs données métiers, les enrichir avec des sources pertinentes, puis les analyser à l’aide de tableaux de bord IA et d’insights automatisés. Cette approche méthodique permet de passer d’un reporting subi à un pilotage intelligent, où chaque donnée devient un levier stratégique de performance.